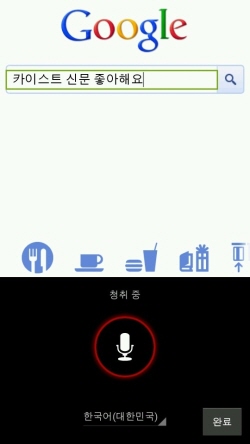

인간이 로봇과 자연스럽게 대화하는 SF 영화를 본 적이 있을 것이다. 이와 유사하게 요즘 아이폰의 Siri와 안드로이드 폰의 음성인식, 그리고 심심이와 같은 자동문답 기능을 가진 스마트폰 애플리케이션과 프로그램이 스마트폰 사용자들 사이에서 새로운 관심사로 급부상했다. Siri의 한국어 버전이 나온 가운데 각 애플리케이션과 프로그램들을 비교하는 것에도 사람들의 관심이 집중되고 있다. 사람이 소리를 내는 원리부터 지능이 부여된 심심이, 아이폰의 Siri, 안드로이드 폰의 음성인식 애플리케이션의 언어인식 체계의 차이점이 무엇인지 알아보자.

사람이 소리를 내는 원리

공기는 목에 있는 성문(聲門)을 지나게 되는데, 성문에는 성대(聲帶)라는 한 쌍의 주름이 있다. 이 부분이 우리가 ‘아~’, ‘어~’ 등의 음을 발성하면서 목에 손을 댔을 때 진동을 하며 떨린다. 그렇다면 이 ‘아~’, ‘어~’와 같은 소리의 언어적 정보는 어디서 만들어질까. 성대에서 입술과 콧구멍까지의 통로를 지나는 공기는 여러 가지 음으로 만들어지는데, 이 구간을 성도라고 부른다. 성도의 상태, 즉 입을 벌린 크기, 혀끝의 위치 등에 따라 다양한 소리가 나오게 된다.

음성 파형을 음편으로 나누어 분석해

음성 인식기는 음성 파형이 주어지게 되면 매 0.01초 단위로 그 시점에 있는 약 0.02초 정도 길이의 음편을 가져와서 분석하게 된다. 이 짧은 길이의 음성 파형은 여러 단계의 신호 처리를 거쳐 최종적으로 10개 이상의 숫자들이 나오게 되는데, 이 숫자들은 인간의 성대 진동 횟수와 음의 높낮이 등을 미리 분석해 만들어놓은 결과물과 비교해 산출한 것이다. 이 정보를 이용해 그 순간의 성대 진동과 입모양을 추론한다. 그 숫자들 중 음파의 진동수와 관련된 정보는 언어 정보를 인식하는데 도움이 되지 않는다. 같은 말을 발음하면 음파의 진동수가 달라도 같은 언어로 인식하는데, 이는 언어정보가 음의 높낮이와 관련이 없기 때문이다. 예를 들어, 어떤 발음에 대해 남자와 여자가 내는 음의 높낮이는 서로 다르지만 그 발음에 대해 모두 같은 언어 정보를 추출하게 된다.

어순에 따라 의미 분석 가능해야

음성인식 기술은 그 기술의 난이도에 따라 크게 ‘고립 단어 인식’과 ‘연속 음성인식’으로 나뉜다. 예를 들어 인식 대상 어휘가 ‘휴대폰’, ‘노트북’ 두 개라고 가정하자. 전자는 ‘휴대폰’, ‘노트북’ 두 개의 어휘만 인식하는 기술이고, 후자는 이 두 개 어휘의 가능한 모든 조합, 즉 ‘휴대폰 휴대폰’, ‘노트북 휴대폰 노트북’과 같이 어떠한 길이의 어휘 조합도 모두 인식하는 기술이다. 전자는 인식해야 하는 어떤 단어 조합이라도 ‘휴대폰’, ‘노트북’ 두 가지 어휘만 인식할 수 있고 후자는 두 가지 어휘로 만든 모든 조합을 다르게 판단해 인식할 수 있다. 후자가 더욱 어려운 기술로, 같은 단어를 포함해도 길이와 조합에 따라 다르게 인식하는 사람과 비슷한 수준의 음성인식 기술을 개발하려면 후자의 기술이 사용되어야 한다.

가능성이 낮은 단어열부터 제외해

후보가 되는 모든 단어 열에 대한 확률을 구하면 음성 인식기는 그 중 가장 가능성이 높은 단어 열을 선택하도록 되어있다. 하지만 단어 열 길이에 제한이 없으므로 우리가 찾아야 하는 탐색 공간이 어디서부터 어디까지인지 모르게 된다. 그러므로 어떻게 빠르고 정확하게 단어 열을 찾을 것인지가 가장 중요한 문제가 된다. 이를 해결하는 방법은 생각보다 단순하다. 모든 후보 단어 열에 대한 가능성을 열어두고 음성을 듣다가 가장 가능성이 낮은 음성부터 후보에서 탈락시키는 방법이다. 이로써 음성 신호가 모두 처리되었을 때 탈락하지 않고 가장 끝까지 남아있는 후보가 최종 인식 결과가 된다.

똑똑한 Siri의 비밀, 울프람알파

아이폰 4S에 탑재되어 있는 Siri라는 음성인식 프로그램은 기기 내부에 사람이 있는 듯, 생각이 담긴 듯한 말을 하곤 한다. 이것은 울프람알파(Wolframalpha)라는 검색엔진을 사용한 덕택이다. 이 검색엔진은 논리적인 답을 스스로 찾아내는 능력을 갖추고 있다. 울프람알파는 인공지능 검색엔진으로 슈퍼컴퓨터를 이용해 웹상의 지식을 재구성한 후 사용자들에게 제공한다.

원격 제어도 가능해

아이폰의 Siri가 단순한 음성인식 프로그램이라고만 생각한다면 큰 오산이다. 작년 12월 Siri와 ‘바이퍼 스마트 스타트’라는 애플리케이션을 이용해 자동차를 다루는 영상이 공개되었다. ‘바이퍼 스마트 스타트’는 스마트폰을 리모컨처럼 활용해 자동차를 원격 제어할 수 있는 애플리케이션이다. Siri와 바이퍼 스마트 스타트는 Siri에 음성명령을 내려 자동차의 시동을 걸도록 했다. 같은 원리로 차 문을 열거나 잠그는 것은 물론, 트렁크를 여는 등 다양한 기능을 수행할 수 있다. 이처럼 조금만 더 응용할 수 있다면 날씨, 기분 등을 물어보는 단순한 음성인식에서 원격 조종까지 다양한 방법으로 우리의 삶을 도와줄 수 있다.

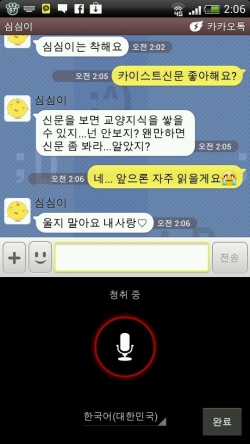

자동응답 프로그램의 선구, 심심이

심심이는 네트워크 콘텐츠 회사 이즈메이커의 온라인 인공지능 채팅 로봇이다. 지난 2002년 MSN 심심이로 만들어졌으며 지난 2010년에는 애플리케이션으로도 출시되었다. 아이폰의 Siri와 안드로이드 폰의 음성인식 애플리케이션이 개발되기 전부터 인터넷에서 메신저 프로그램을 통해 보급되고 있었다. 이는 사용자의 문자를 인식해 답변을 해주는 애플리케이션이나 프로그램 중에서 상당히 초기에 개발되었다.

심심이가 사람처럼 말할 것

현재 심심이의 단순 언어 체계에 지능을 부여해 인공지능적인 기능을 살리는 연구를 우리 학교 전산학과 박종철 교수팀이 진행하고 있다. 박 교수팀은 이즈메이커와 ‘대화형 로봇 심심이 대화 능력 향상을 위한 공동 연구’ 개발 과제 계약을 체결하고, 관련 연구에 돌입했다. 이번 연구의 주제는 ‘일관된 문체를 가지는 대화 에이전트 답변을 위한 캐릭터 기반 답변 생성 연구’이다. ‘대화 에이전트 기술’이란 사람과 컴퓨터가 서로 의사소통하는 기술이다. 연구의 핵심은 심심이가 ‘대화 에이전트 기술’을 사용해 사용자들이 저장한 어록에서 임의로 선정되는 것과 달리 사람과 말하는 것처럼 일관된 문체의 답변을 제공하게 하는 것이다. 이전에는 심심이가 데이터베이스에 저장된 표현만을 사용해 간혹 사용자들의 의도와 맞지 않는 답변을 했었다. 그래서 이를 보완하고자 박 교수팀은 사용자들이 저장한 정보들을 바탕으로 무작위로 대답하는 기존의 형식에 심심이가 사용자들의 대화 방식을 분석하고 판단해 마치 사람과 대화하는 것처럼 인공지능을 정교화하는 연구를 하고 있다. 심심이가 대화 시 사용자들이 원하는 화법과 어투를 유지하며 답변하는 것이 연구의 목표다.

미래에는 일상생활에 기계, 컴퓨터 프로그램과 의사소통하고, 심지어는 감정을 공유하는 일도 일어날 것이다. 기술이 발달할수록 사회가 발전하고, 나아가 인간과 소통할 수 있는 개체가 다양해지게 된다. 사용자 중심 인터페이스의 중요성이 부각되고 유비쿼터스 시대로 발전하고 있는 현 시점에 이러한 기술의 발달은 매우 중요한 의미를 갖는다. 더 나아가, 인간을 대신할 로봇 도우미나 사람과 소통이 가능한 로봇을 만들 수 있다면, 인간 사회에 새로운 지평을 열 수 있을 것이다.